Что такое веллум?

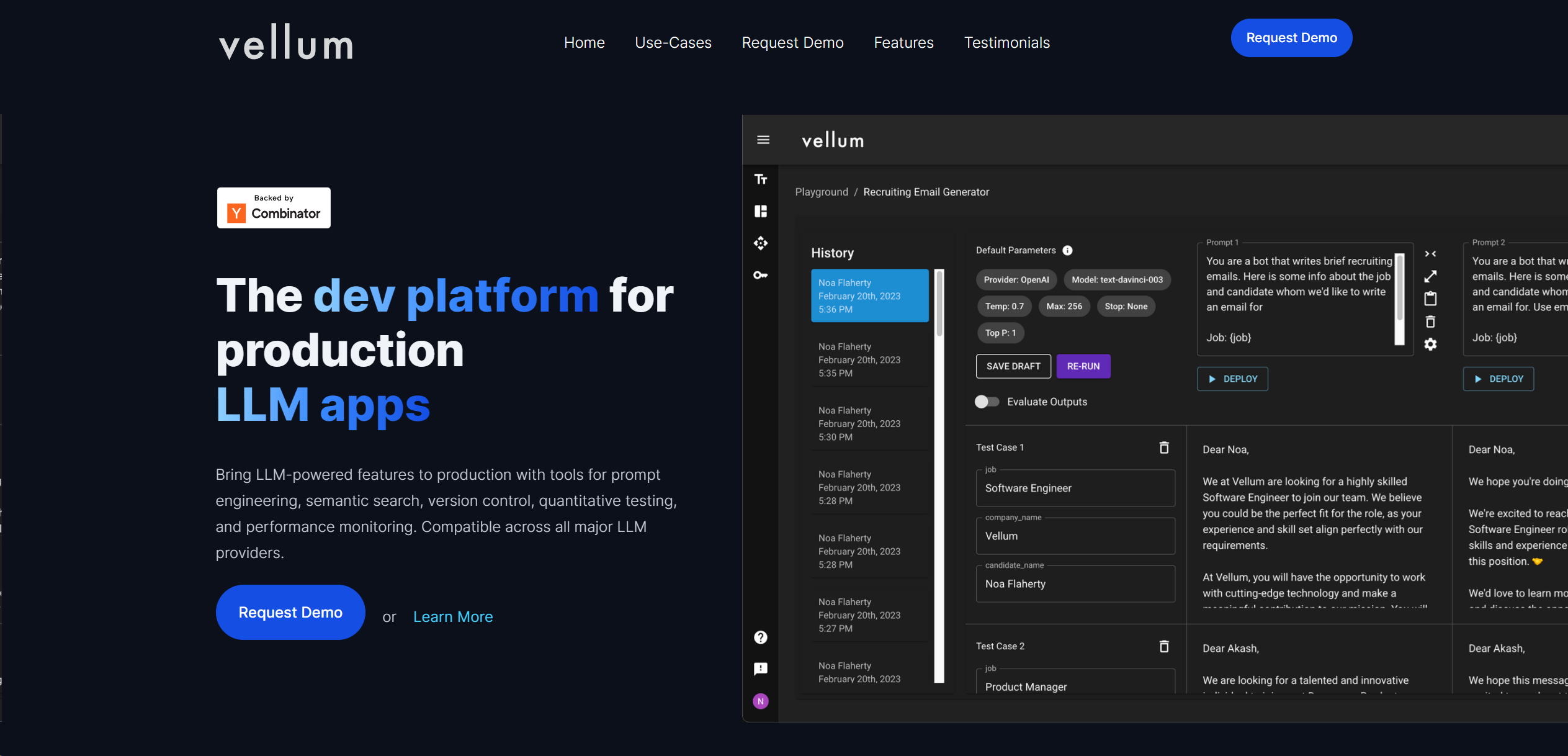

Vellum – это передовая платформа для разработки продуктов ИИ, позволяющая пользователям уверенно внедрять функции на основе больших языковых моделей (LLM). Она предназначена для широкого спектра приложений, включая автоматизацию рабочих процессов, анализ документов, тонкую настройку моделей машинного обучения и различные формы создания контента. Предназначенный для профессионалов и организаций, стремящихся использовать возможности ИИ, Vellum упрощает сложный процесс интеграции ИИ в производственные среды.

Ключевые особенности:

Интеграция с Microsoft Azure Hosted OpenAI Models:

Поддерживает использование размещенных в Microsoft Azure моделей OpenAI, что повышает универсальность.

Автоматизация рабочих процессов:

Оптимизация процессов за счет автоматизации сложных рабочих процессов, экономии времени и повышения эффективности.

Возможности тонкой настройки:

Позволяет пользователям точно настраивать модели для конкретных случаев использования, повышая производительность.

Комплексные инструменты оценки:

Предоставляет надежные инструменты для оперативного тестирования и оценки моделей, чтобы обеспечить качество перед развертыванием.

Развертывание и мониторинг:

Обеспечивает развертывание функций ИИ в режиме реального времени с мониторингом надежности.

Плюсы:

Простота использования:

Удобный интерфейс упрощает взаимодействие со сложными функциями ИИ.

Масштабируемость:

Высокомасштабируемая архитектура подходит для предприятий любого размера.

Удобство для совместной работы:

Обеспечивает беспрепятственное взаимодействие между членами команды, включая нетехнический персонал.

Соответствие требованиям безопасности:

Придерживается лучших в своем классе стандартов безопасности, включая соответствие стандартам SOC2 и HIPAA.

Постоянное совершенствование:

Позволяет постоянно совершенствовать функции LLM в процессе производства с точки зрения качества, стоимости и задержки.

Конс:

Кривая обучения:

Новым пользователям может потребоваться время, чтобы разобраться в обширных возможностях платформы.

Зависимость от сторонних моделей:

Зависимость от внешних провайдеров LLM, что может привести к изменению доступности или производительности услуг.

Прозрачность ценообразования:

Для получения подробной информации о ценах может потребоваться прямой запрос.

Кто использует Vellum?

Технологические стартапы:

Быстрое развертывание функций на базе LLM с небольшими командами разработчиков.

Организации здравоохранения:

Использование искусственного интеллекта для обработки конфиденциальных данных в соответствии с требованиями HIPAA.

Образовательные учреждения:

Использование ИИ для повышения эффективности обучения и административной эффективности.

Службы поддержки клиентов:

Использование чат-ботов и инструментов генерации контента для улучшения взаимодействия с клиентами.

Необычные случаи использования:

Инженеры, не являющиеся сотрудниками ML, создают, развертывают и управляют моделями без предварительных знаний в области ИИ; команды разработчиков продуктов, сотрудничающие в разработке функций ИИ.

Ценообразование:

Индивидуальные планы:

Индивидуальные решения, основанные на потребностях предприятия.

Запрос демонстрации:

Потенциальные пользователи могут изучить возможности до принятия решения.

Отказ от ответственности:

Актуальную и точную информацию о ценах см. на официальном сайте Vellum.

Что делает Vellum уникальным?

Vellum выделяется своими надежными инструментами оценки и развертывания для оперативного проектирования и автоматизации рабочих процессов. Он обеспечивает высокую степень кастомизации и непрерывное совершенствование, что крайне важно для беспрепятственной интеграции приложений ИИ в производственные среды.

Совместимость и интеграция:

Microsoft Azure:

Бесшовная интеграция для использования моделей OpenAI.

Доступ к API:

Повышает адаптивность благодаря доступу к API для пользовательских интеграций.

Инструменты для совместной работы:

Поддержка совместной работы с несколькими членами команды над рабочими процессами ИИ.

Конфиденциальность данных:

Настраиваемые параметры хранения данных и доступа к ним отвечают различным требованиям конфиденциальности.

Учебные пособия Vellum:

Для ознакомления пользователей с платформой доступны обучающие ресурсы, включая учебники по оперативному проектированию и автоматизации рабочих процессов.

Как мы его оценили:

Точность и надежность:

4.6/5

Простота использования:

4.2/5

Функциональность и возможности:

4.5/5

Производительность и скорость:

4.4/5

Настройка и гибкость:

4.7/5

Конфиденциальность и безопасность данных:

4.8/5

Поддержка и ресурсы:

4.3/5

Экономическая эффективность:

4.1/5

Интеграционные возможности:

4.5/5

Общая оценка:

4.5/5

Резюме:

Vellum отлично подходит в качестве платформы для разработки ИИ-продуктов, предлагая предприятиям инструменты для эффективного развертывания функций на базе LLM. Ее возможности по автоматизации рабочих процессов, тонкой настройке, оценке и развертыванию делают ее ценной для интеграции ИИ в производственные системы. Ориентируясь на совместную работу, масштабируемость и безопасность, Vellum поддерживает различные приложения ИИ в разных отраслях.