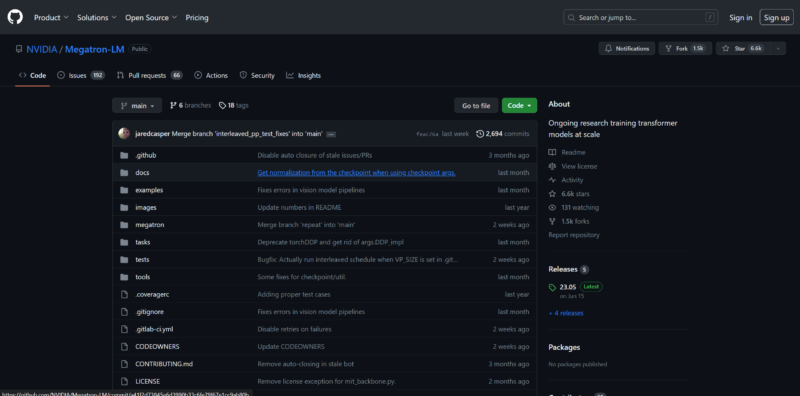

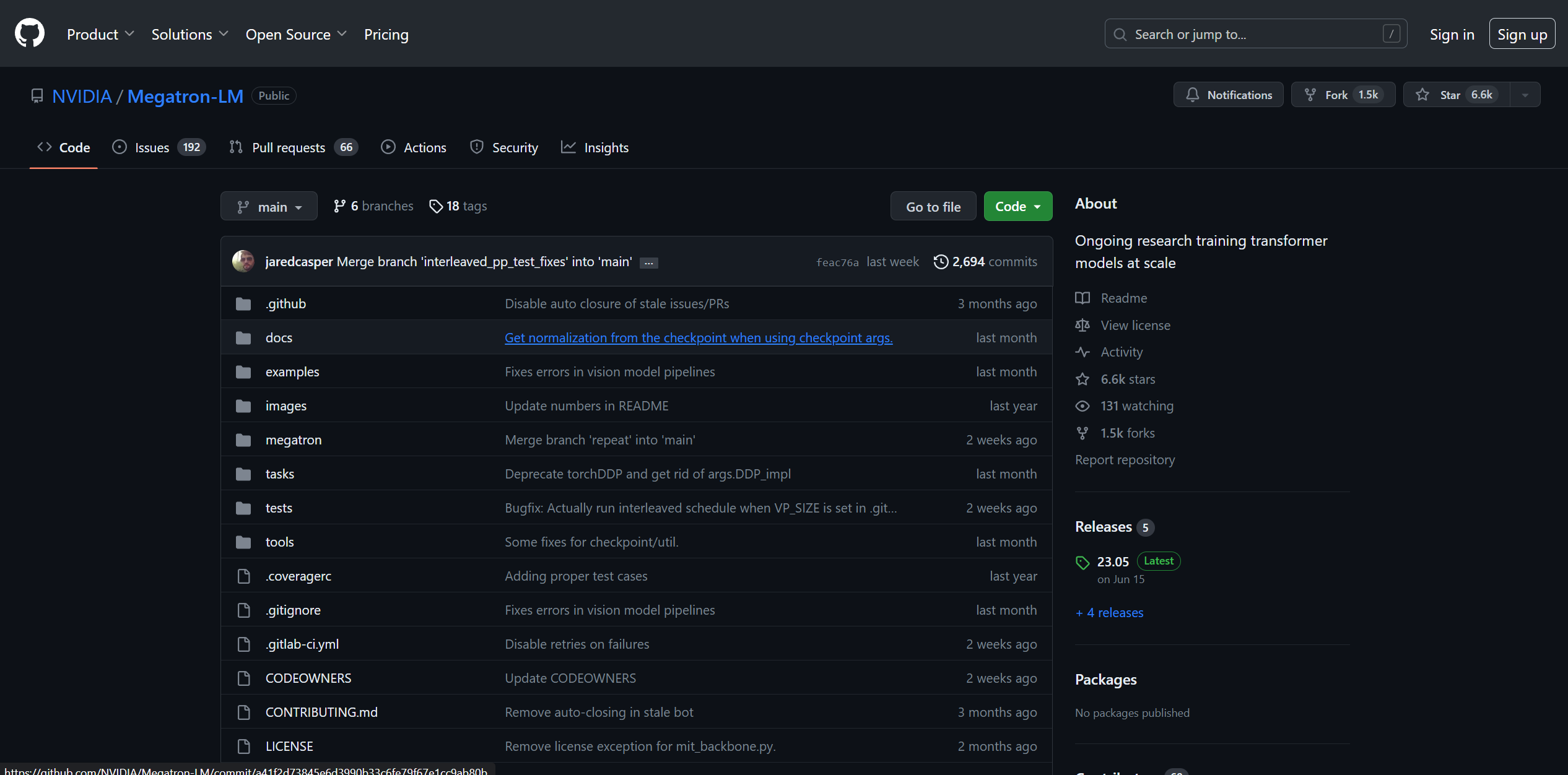

Megatron

предлагаемая в трех итерациях (1, 2 и 3), является надежной и высокопроизводительной трансформаторной моделью, разработанной командой NVIDIA по прикладным исследованиям в области глубокого обучения. Эта инициатива направлена на развитие исследований в области больших трансформаторных языковых моделей

. Megatron был разработан, чтобы облегчить обучение этих моделей в огромных масштабах, что делает его ценным активом для многочисленных приложений.

Ключевые моменты:

Эффективный параллелизм моделей:

Megatron использует методы параллелизма моделей для тензорной, последовательной и конвейерной обработки. Такая эффективность обеспечивает плавное и масштабируемое обучение моделей, особенно в сценариях с большими моделями трансформаторов, таких как GPT, BERT и T5.

Смешанная точность:

Megatron использует смешанную точность для повышения эффективности обучения крупномасштабных языковых моделей. Эта стратегия оптимизирует использование аппаратных ресурсов для повышения эффективности работы.

Проекты, использующие Megatron:

Megatron был использован в широком спектре проектов, демонстрируя свою универсальность и вклад в различные области. Среди таких проектов можно выделить следующие:

Исследования BERT и GPT с использованием Megatron

BioMegatron: Достижения в области языковых моделей биомедицинских доменов

Конечное обучение нейронных ретриверов для ответов на вопросы в открытых доменах

Крупномасштабное многоаспектное генеративное диалоговое моделирование

Разговорные агенты с поддержкой локальных знаний

MEGATRON-CNTRL: Управляемая генерация историй с помощью внешних знаний

Достижения в таблице лидеров набора данных RACE Reading Comprehension Dataset

Обучение моделей ответов на вопросы на основе синтетических данных

Выявление социальных предубеждений с помощью коротких инструкций

Исследование доменно-адаптивного обучения для детоксикации языковых моделей

Использование DeepSpeed и Megatron для обучения Мегатрон-Тьюринг NLG 530B

NeMo Megatron:

Megatron находит применение в NeMo Megatron – комплексном фреймворке, предназначенном для решения сложных задач построения и обучения продвинутых моделей обработки естественного языка с миллиардами и даже триллионами параметров. Этот фреймворк особенно полезен для предприятий, занимающихся крупномасштабными NLP-проектами.

Масштабируемость:

Кодовая база Megatron хорошо оснащена для эффективного обучения массивных языковых моделей с сотнями миллиардов параметров. Эти модели демонстрируют масштабируемость при различных настройках GPU и размерах моделей. Диапазон охватывает модели GPT с параметрами от 1 миллиарда до ошеломляющего 1 триллиона. В исследованиях масштабируемости использовался суперкомпьютер Selene от NVIDIA, в котором задействовано до 3072 графических процессоров A100 для самой обширной модели. Результаты бенчмарков демонстрируют впечатляющее линейное масштабирование, подчеркивая возможности производительности Megatron.